安装方法

第一种

通过manager搜索 was-node-suite-comfyui下载即可。

第二种

第二种

- 进入 ComfyUI 的 custom_nodes 目录,并打开cmd。

- 使用以下命令克隆仓库:

git clone https://github.com/WASasquatch/was-node-suite-comfyui.git1.安装相应库文件

==虚拟环境==

pip install -r requirements.txt==内置python环境==

python -m pip install -r requirements.txtBLIP模型:

- BLIP 模型的作用可以概括为“让模型看图并用自然语言理解和表达”。它把视觉特征和语言模型结合起来,完成图像到文本、文本到图像理解相关的多种任务。

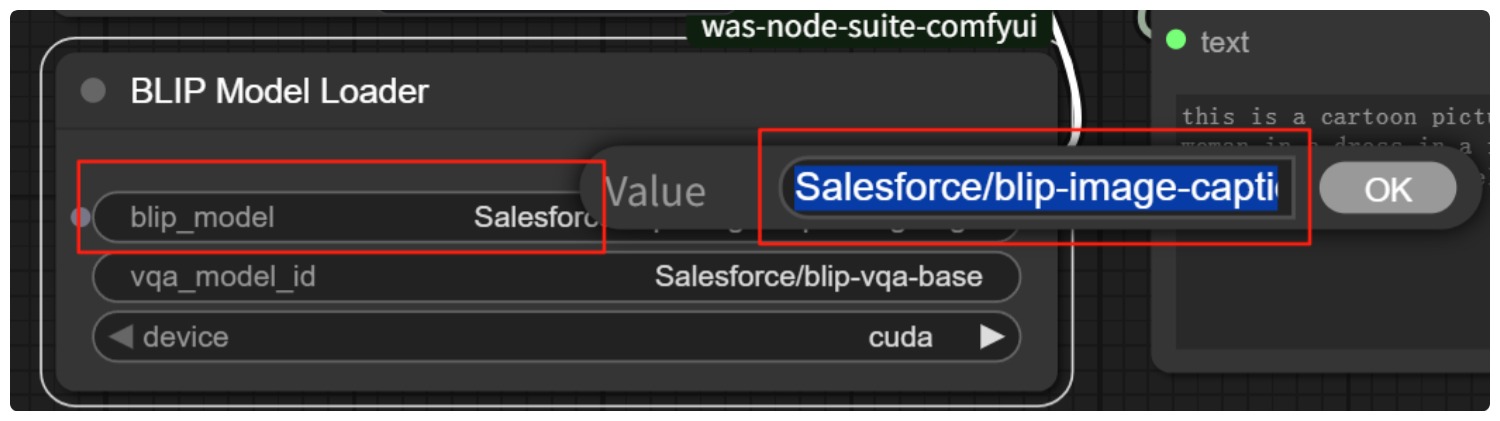

- BLIP 模型不用手动下载,而是在含有BLIP Model Loader节点的工作流运行时自动下载,其文件下载放置路径为comfyUI/models/blip/。 在BLIP Model Loader节点blip_model一栏点击右侧英文,出现Value输入框,可以输入要使用的BLIP模型版本。点击工作流运行按钮后,工作流即自动下载所输入的模型版本,同时加载到工作流中。

- BLIP一代典型用途:图像描述(Caption)、视觉问答(VQA)、图文检索。用于Caption的模型版本为:Salesforce/blip-image-captioning-base和Salesforce/blip-image-captioning-large;用于VQA的模型版本为:Salesforce/blip-vqa-base和Salesforce/blip-vqa-capfilt-large(带过滤增强);用于图文检索的模型版本为:Salesforce/blip-itm-base-coco、Salesforce/blip-itm-large-coco(ITM/对齐判别)、Salesforce/blip-itm-base-flickr和Salesforce/blip-itm-large-flickr。

- BLIP二代为BLIP-2(视觉编码器(ViT-g/ViT-L/ViT-H 等) + Q-Former + 外接语言模型(OPT和FLAN-T5 )),典型用途:更强的多模态理解与生成,适合 Caption、VQA、指令式问答/对话。其OPT版本为:Salesforce/blip2-opt-2.7b(资源友好、功能全面,3090/24G可用),Salesforce/blip2-opt-6.7b(更强,显存要求更高);FLAN-T5版本为:Salesforce/blip2-flan-t5-xl(指令理解更自然,24G常可运行),Salesforce/blip2-flan-t5-xxl(极大,单卡24G基本不可行)。

- 注意:BLIP二代不能用在BLIP Model Loader节点里,而应在支持 BLIP2 的节点里使用。